توضیحات

ABSTRACT

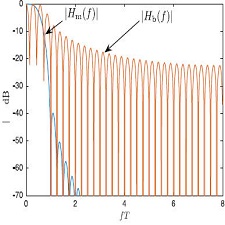

In this paper, to address the issue that ensembling k-nearest neighbor (kNN) classifiers with resampling approaches cannot generate component classifiers with a large diversity, we consider ensembling kNN through a multimodal perturbation-based method. Since kNN is sensitive to the input attributes, we propose a weighted heterogeneous distance Metric (WHDM). By using a WHDM and evidence theory, a progressive kNN classifier is developed. Based on a progressive kNN, the random subspace method, attribute reduction, and Bagging, a novel algorithm termed RRSB (reduced random subspace-based Bagging) is proposed for construct ensemble classifier, which can increase the diversity of component classifiers without damaging the accuracy of the component classifiers. In detail, RRSB adopts the perturbation on the learningparameter with a weighted heterogeneous distance metric, the perturbation on the input space with random subspace and attribute reduction, the perturbation on the training data with Bagging, and the perturbation on the output target of k neighbors with evidence theory. In the experimental stage,the value of k, the different perturbations on RRSB and the ensemble size are analyzed. In addition,RRSB is compared with other multimodal perturbation-based ensemble algorithms on multiple UCI data sets and a KDD data set. The results from the experiments demonstrate the effectiveness of RRSB for kNN ensembling.

INTRODUCTION

Ensemble learning has been a prominent topic in the field of machine learning in recent years, and it is listed as the first of four research directions in machine learning research by Dietterich . To enhance the generalization performance of ensemble learning, many different approaches have been proposed for training accurate but diverse component classifiers. According to the mode of training the classifier, the typical ensemble approaches can be divided into three cases : component classifier is trained on a different attribute subspace. component classifier is trained on different resampling training data. component classifier is trained on a data set with several different parameters. The ensemble scheme may take into account any of the above three techniques. For example, each component classifier is trained on a randomly selected attribute space in the case of the random subspace method (RSM) . Ho first proposed RSM and applied it in a decision tree ensemble and then investigated RSM in a kNN .ensemble

چکیده

در این مقاله با توجه به مسئله ای که طبقه بندی های k-nearest همسایه (kNN) با استفاده از رویکرد resampling می تواند طبقه بندی های مولد را با تنوع زیادی ایجاد نمی کند، ما kNN را از طریق روش متضاد متقابل به کار می بریم. از آنجا که kNN به ویژگی های ورودی حساس است، ما یک Metric (WHDM) با فاصله ناهمگن وزنی پیشنهاد می کنیم. با استفاده از WHDM و تئوری شواهد، طبقه بندی پیشرفته kNN توسعه یافته است. بر اساس یک kNN پیشرفته، روش زیرمجموعه تصادفی، کاهش ویژگی و Bagging، یک الگوریتم جدید RRSB (کاهش بسته بندی تصادفی بر مبنای تصادفی بر اساس طبقه بندی سازنده) پیشنهاد شده است که می تواند تنوع طبقه بندی های سازنده را بدون آسیب رساندن به دقت طبقه بندی اجزاء. به طور دقیق، RRSB اختلال در پارامتر یادگیری را با ماتریس فاصله ناهمگن وزن، اختلال در فضای ورودی با فضای تصادفی و کاهش ویژگی، اختلال در داده های آموزشی با Bagging و اختلال در هدف خروجی k همسایگان با تئوری شواهد در مرحله آزمایشی، مقدار k، اختلالات مختلف بر روی RRSB و اندازه ی گروه تحلیل می شود. علاوه بر این، RRSB با دیگر الگوریتم های ترکیبی مبتنی بر وقفه های چندجمله ای در مجموعه داده های چندگانه UCI و مجموعه داده KDD مقایسه می شود. نتایج آزمایشات اثربخشی RRSB را برای مجموعه kNN نشان می دهد.

مقدمه

یادگیری گروهی در سالهای اخیر یکی از موضوعات مهم در زمینه یادگیری ماشین بوده است و به عنوان اولین از چهار جهت تحقیق در تحقیقات ماشینکاری توسط Dietterich ذکر شده است. برای ارتقاء عملکرد عمومی سازی یادگیری گروهی، روش های متفاوتی برای طبقه بندی دقیق، اما متنوعی از مولفه های مختلف ارائه شده است. طبق روش آموزش طبقه بندی، روش های معمول گروه می تواند به سه مورد تقسیم شود: طبقه بندی سازنده بر روی یک زیرمجموعه ویژگی متفاوتی آموزش داده می شود. ● سازنده کامپوننت ها بر روی داده های مختلف آموزش resampling آموزش داده می شود. طبقه بندی سازنده در یک مجموعه داده با چند پارامتر مختلف آموزش دیده است. طرح گروه می تواند هر یک از سه تکنیک فوق را در نظر بگیرد. به عنوان مثال، هر سازنده جزء در مورد یک فضای تصادفی انتخاب شده در مورد روش زیر فضای تصادفی (RSM) آموزش داده می شود. Ho اول RSM را پیشنهاد کرد و آن را در یک گروه تصمیم گیری درخت تصمیم گرفت و سپس RSM را در یک kNN بررسی کرد

Year: 2018

Publisher : ELSEVIER

By : Youqiang Zhang , Guo Cao , Bisheng Wang , Xuesong Li

File Information: English Language/ 28 Page / size: 0.98 MB

سال : 1396

ناشر : ELSEVIER

کاری از : Youqiang ژانگ، Guo کائو، Bisheng وانگ، Xuesong لی

اطلاعات فایل : زبان انگلیسی / 28 صفحه / حجم : MB 0.98

نقد و بررسیها

هنوز بررسیای ثبت نشده است.